Quelle: Pixabay

Die RWTH Aachen und das IT Center beschäftigen sich intensiv mit Fragen der Langzeitarchivierung von Daten. bitstream preservation ist die Grundvoraussetzung der Langzeitarchivierung. Ein Bitstream stellt eine festgelegte Abfolge von Bits dar, die den Wert 0 oder 1 haben und auf Datenträgern digital gespeichert werden. Daten digital zu archivieren bedeutet, einen ersten Schritt dahingehend zu unternehmen, dass die Daten auch zukünftig noch genauso verfügbar sind, wie sie archiviert wurden. Ein weiterer wesentlicher Bestandteil der Langezeitarchivierung ist die Datenspeicherung, die sich von der Langzeitarchivierung durch den vorgegebenen zeitlichen Rahmen der Datenhaltung unterscheidet. Die Maßnahmen zur Sicherung der Daten wird hier nun am Beispiel des an der RWTH eingesetzten Archivsystems von IBM erklärt.

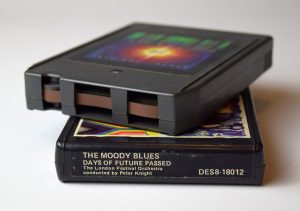

Entsprechen einer weit verbreiteten Art der digitalen Datenspeicherung erfolgt die Archivierung der Daten auf Magnetbändern, auf denen Daten aufgrund der langen Datenhaltung besonders energieeffizient und kostengünstig gespeichert werden können. Die Bandspeichersysteme werden durch eine Software und mithilfe eines insgesamt Petabyte großen Datenbanksystems verwaltet und gesteuert. Um die Performance bei der Ein- und Auslieferung der Daten zu erhöhen, verfügt das System zusätzlich über Festplattenspeichersysteme. So können pro Nacht bis zu 250 Terabyte bewegt und im Regelfall um die 80 TByte pro Nacht Daten verarbeitet werden.

Zur Sicherung der Daten werden zwei Taktiken verfolgt: Die Speicherung redundanter Kopien und die regelmäßige Überprüfung der Daten.

Alle eingelieferten Daten werden redundant auf zwei verschiedenen Bändern gespeichert. Sollten also Teile der Daten auf einem Band verloren gehen, können Sie durch die andere Kopie wiederhergestellt werden. Zudem werden die Daten auch noch zum Forschungszentrum Jülich gespiegelt, so dass für den Katastrophenfall Standortredundanz gesichert ist.

Zum anderen wird die Integrität der Daten durch das Bilden und Vergleichen von Hash-Werten überprüft, wenn eine Operation (Einliefern, Kopieren, Ausliefern) stattfindet. Zusätzlich erfolgt diese Überprüfung ereignisunabhängig in regelmäßigen Abständen. So fallen Defekte an den Daten auf und können dann durch Nutzung anderer Kopien repariert werden. Auch die einzelnen Bänder werden regelmäßig geprüft. Im Falle eines Defektes wird dieser durch IBM analysiert und kann in den meisten Fällen repariert werden.