Quelle: ProPE

Das Jahr neigt sich dem Ende und wir möchten Sie mit einer Blog-Serie durch den Advent begleiten. Im Rahmen des Projektes ProPE, gefördert durch die Deutsche Forschungsgesellschaft, möchten wir Ihnen Einblicke in die Welt des Performance Engineerings gewähren. Jeden Freitag bis Weihnachten stellen wir Ihnen spannende Beiträge aus den Bereichen Performance Monitoring, Shared Knowledgebase und der standortübergreifenden Supportstruktur vor, die von dem ProPE-Projektteam der RWTH Aachen University zur Verfügung gestellt werden.

Automatisches Sammeln Performance-relevanter Messdaten durch Monitoring der Rechenjobs auf dem Hochleistungsrechner CLAIX: Die neue Infrastruktur am IT Center, die im Rahmen des Projekts ProPE entstanden ist, ermöglicht eine bessere Identifikation von Rechenjobs mit ineffizienter Performance und somit auch Optimierungspotenzial für Nutzerjobs.

Für CLAIX-2016 und CLAIX-2018 setzt das IT Center auf eine dauerhafte Performance-Überwachung der Rechenknoten. Dabei entfällt der sonst übliche Aufwand für den Nutzer, entsprechende Tools manuell einzubinden und erleichtert die (nachträgliche) Analyse und den Vergleich von Batch-Jobs. Aktuell wird zudem eine automatische Datenauswertung evaluiert, um damit Performance-Probleme in den laufenden Applikationen zu detektieren.

Aus Datenschutzgründen sind die Monitoring-Daten zurzeit noch nicht direkt für Nutzer des HPC-Clusters einsehbar. Es wird aber an einer entsprechenden Lösung gearbeitet, sodass Entwickler die Daten effektiv für die Verbesserung eigener HPC-Codes einsetzen können. Sollten Sie in der Zwischenzeit bereits Interesse an der Analyse haben, können Sie sich unter Angabe der Job-ID, der Hostnamen und des Zeitraums an den ServiceDesk wenden.

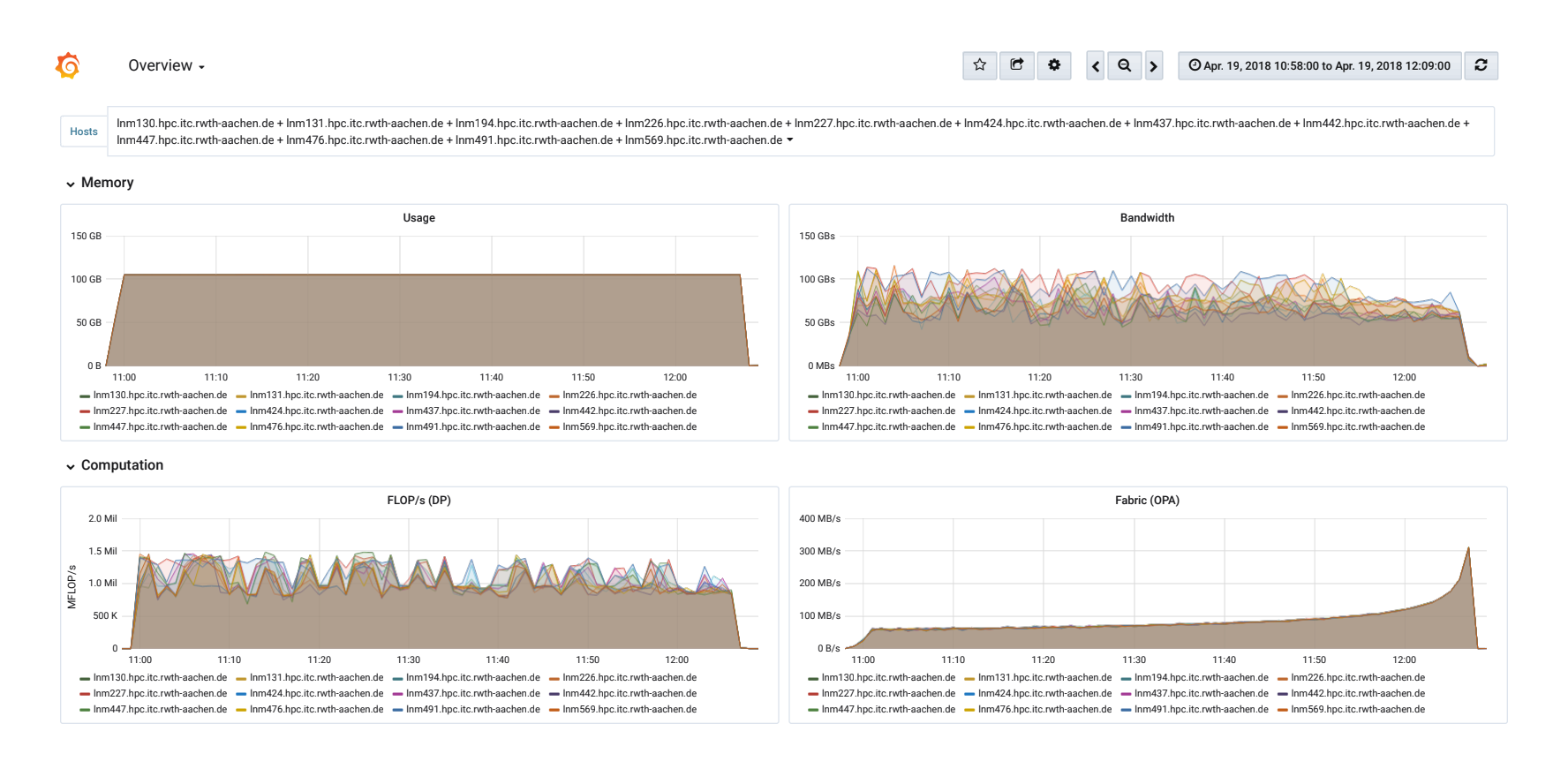

Visualisierung des Performance Monitorings in Grafana. Zu sehen ist die Ausführung des High Performance Linpacks (HPL) auf 12 MPI-Knoten von CLAIX-2016. Dieser Benchmark bildet die Grundlage des Rankings in der Top500.

Quelle: ProPE

Technische Umsetzung

Zur Speicherung der Daten setzt das IT Center auf die Time Series Database (TSDB) InfluxDB. Zur eigentlichen Überwachung läuft auf jedem Knoten der Monitoring-Daemon Telegraf. Dieser wurde dahingehend erweitert, dass HPC-relevante Metriken wie die Auslastung des OmniPath-Netzwerkes und des parallelen Dateisystems Lustre erfasst wird. Außerdem nutzt der Daemon das Tool likwid zum Auslesen von Performance-Countern, um unter anderem Informationen über die Taktfrequenz, die ausgeführten Floating Point Operations per Second (FLOP/s) und die genutzte Speicherbandbreite zu erhalten.

Bei der Umsetzung wurde darauf geachtet, den Overhead sehr klein zu halten, der durch eine dauerhafte Messung entstehen kann. Aus diesem Grund werden die Daten (nur) einmal in der Minute gemessen, wobei in keiner der getesteten Anwendungen eine signifikante Auswirkung sichtbar war. Diese Frequenz stellt damit einen Kompromiss zwischen dem Overhead und der anfallenden Datenmenge auf der einen sowie der dennoch ausreichenden Auflösung auf der anderen Seite dar. Seiteneffekte des dauerhaften Monitorings können entstehen, wenn andere Analyse-Tools gleiche Hardware-Register verwenden. Um eine gegenseitige Störung und falsche Ergebnisse zu verhindern, können Nutzer entsprechende Parameter im Job-Skript setzen (bitten beachten Sie die entsprechende Dokumentation auf IT Center Help, insbesondere zu Intel VTune und likwid).

Das Projekt ProPE wird von der Deutschen Forschungsgemeinschaft (DFG) für drei Jahre gefördert (2/2017 – 1/2020). Das Ziel des Projekts ist die Entwicklung eines Konzepts für eine nachhaltige, strukturierte und prozessorientierte Service-Infrastruktur, die das Performance Engineering (PE) von Simulationsanwendungen an deutschen Hochleistungszentren im Bereich Tier-2 und Tier-3 fördert. Das Projekt wird von den folgenden Partnern getragen: FAU Erlangen-Nürnberg, TU Dresden, RWTH Aachen.

Verantwortlich für die Inhalte dieses Beitrags sind:

Sandra Wienke/ Jonas Hanfeld: Text & Bild

Sara Kaya: Content Management